Event‑getriebene Transaktionsmails: Von Stripe‑Fehler bis Passwort‑Reset – sauber umgesetzt

Event‑getriebene Transaktionsmails: Von Stripe‑Fehler bis Passwort‑Reset – sauber umgesetzt

Einleitung

Transaktionale E-Mails – von der Willkommensmail über Passwort-Reset bis zu Rechnungs- und Dunning-Nachrichten bei Zahlungsausfällen – sind das Rückgrat der Kommunikation vieler SaaS-Produkte. Sie informieren Nutzer in Echtzeit über wichtige Ereignisse und beeinflussen maßgeblich die User Experience. Doch wie stellt man sicher, dass solche E-Mails robust und zeitnah versendet werden, selbst wenn ein Drittanbieter wie Stripe einen Fehler meldet oder wenn tausende Events pro Minute anfallen? Die Antwort liegt in einer event-getriebenen Architektur: Produkt-Events wie “Billing Failed” , “Signup Completed” oder “Password Reset Requested” lösen automatisch E-Mails aus, entkoppelt vom synchronen Anwendungscode.

In diesem umfassenden Beitrag richten wir uns an Produktteams, Entwickler und Growth-Leads in SaaS-Unternehmen. Wir stellen aktuelle Architektur- und Workflow-Patterns vor, zeigen Implementierungsansätze in TypeScript/JavaScript und Python, diskutieren Event-Schema-Design (inklusive Idempotenz , Retries & Backoff), Template-Versionierung, Datenquellen-Integration (Stripe Webhooks, Segment-Events, eigene Event-Pipelines) sowie Best Practices für QA, Testing und Monitoring. Außerdem beleuchten wir das Konzept eines eigenen Event-Driven Journey Builders , um mehrstufige E-Mail-Flows flexibel abzubilden – jenseits der Grenzen typischer Marketing-Automation-Tools .

Warum event-getriebene Transaktionsmails?

Viele Teams starten mit einfachen Lösungen: Eine Benutzeraktion (z.B. Klick auf "Passwort vergessen") ruft direkt eine E-Mail-Versandroutine auf. Das funktioniert zunächst, birgt aber Risiken. Bei wachsender Last oder komplexeren Workflows wird eine eng gekoppelte Lösung unübersichtlich und fehleranfällig. Hier setzt das event-getriebene Konzept an: Die Anwendung erzeugt bei relevanten Aktionen Events , die asynchron von einem separaten E-Mail-Service verarbeitet werden.

Der Vorteil von Event-Pipelines ist die Lose Kopplung zwischen Auslöser und Mailversand. Der Produzent des Events (etwa das Billing-System) muss nichts über den E-Mail-Versand wissen. Events werden nahe in Echtzeit geliefert , so dass Konsumenten sofort reagieren können 1 . Fällt der Maildienst kurzfristig aus oder muss neu deployt werden, bleibt das Hauptsystem dennoch funktionsfähig – das Event wird zwischengespeichert und später verarbeitet. Diese Decoupling -Strategie erhöht die Robustheit und Skalierbarkeit erheblich.

Ein weiterer Vorteil: Mehrere Konsumenten können auf dasselbe Event reagieren, ohne den Produzenten zu belasten. Ein “Invoice Payment Failed” -Event könnte z.B. eine E-Mail an den Kunden triggern, parallel aber auch ein internes Alert für das Support-Team. Dank Publish/Subscribe -Mechanismus sieht jeder interessierte Service alle Events 1 . Im Gegensatz zu starren point-to-point Integrationen eröffnen Events so eine flexible Erweiterbarkeit.

Use Case Beispiel: Ein Kunde aktualisiert seine Kreditkarte nicht rechtzeitig, so dass Stripe eine fehlgeschlagene Abbuchung meldet. Statt sofort das Abo zu kündigen, generiert Stripe ein invoice.payment_failed Event. Unser event-getriebenes System empfängt dieses Event und triggert automatisiert eine Dunning-E-Mail (Zahlungserinnerung) mit freundlicher Aufforderung zur Aktualisierung der Zahlungsdaten. Durch die event-basierte Infrastruktur erfolgt der Versand sofort nach dem Fehlschlag – kein stündlicher Cronjob, kein manuelles Eingreifen. Gleichzeitig können wir eine Folge-Eventkette anstoßen: etwa weitere Erinnerungs-Mails nach 3, 7 und 14 Tagen, abhängig davon, ob der Kunde inzwischen bezahlt hat (siehe Abschnitt Journey Builder weiter unten).

Zusammengefasst: Event-driven Transaktionsmails ermöglichen nahezu in Echtzeit reagierende Nutzerkommunikation, erhöhen die Zuverlässigkeit durch Entkopplung und schaffen die Basis für komplexe, mehrstufige Workflows – ein echter Mehrwert für wachsende SaaS-Produkte.

Architektur-Patterns für robuste E-Mail-Workflows

Wie sieht eine typische Architektur für event-basierte Transaktionsmails aus? Im Kern besteht sie aus folgenden Bausteinen:

- Event Producer: Das Kernprodukt oder Drittanbieter generiert ein Event, sobald eine relevante Aktion passiert. Beispiele: UserSignedUp , PasswordResetRequested , InvoicePaymentFailed . Diese Events enthalten zumindest einen eindeutigen Typ und oft eine Payload mit IDs oder Daten zum Vorgang.

- Event Router/Message Broker: Ein zentrales System (Message Queue, Event-Bus) empfängt Events und stellt sie den Konsumenten bereit. Häufige Technologien sind z.B. RabbitMQ, AWS SNS/SQS, Apache Kafka oder cloud-basierte Event-Dienste. Wichtig ist, dass das System hochverfügbar ist und bei Peaks Events puffern kann.

- Email Service (Event Consumer): Ein separater Service (oder mehrere), der auf bestimmte Events lauscht und die passende E-Mail auslöst. Er übernimmt die Geschäftslogik: Daten anreichern, Template auswählen, E-Mail versenden über einen SMTP-Server oder Transactional-Email-API (z.B. SendGrid, Mailgun, AWS SES).

Abbildung – Architekturidee: Das Produkt und externe Quellen (z.B. Stripe) publizieren Events an einen Broker. Der E-Mail-Service konsumiert diese Events, generiert aus Vorlagen personalisierte Mails und versendet sie via E-Mail-Provider. Eine eventgetriebene Pipeline wie diese stellt sicher, dass Transaktionsmails zuverlässig und skalierbar verarbeitet werden, selbst bei hohen Volumina.

Diese Architektur entkoppelt die Systeme und ermöglicht fehlertolerante Workflows . Wenn das E-Mail-System kurzzeitig nicht verfügbar ist, bleiben Events in der Queue und gehen nicht verloren. Der Versand erfolgt, sobald der Service wieder läuft – ohne manuelles Nacharbeiten . Für noch höhere Zuverlässigkeit nutzen manche Teams das Transactional Outbox Pattern: Das erzeugende System schreibt neue Events erst in eine lokale Outbox-Tabelle in der Datenbank und committet diese synchron mit der Geschäftsaktion. Ein Outbox-Relay-Prozess liest dann die Tabelle und publiziert Events garantiert genau einmal in den Broker 2 3 . So werden Datenbank-Änderung und Event-Publikation atomar gekopppelt, ohne verteilte Transaktionen.

Idempotenter Konsum: In verteilten Architekturen ist es üblich, dass Nachrichten auch mal doppelt ankommen oder erneut versucht werden (z.B. nach Fehlern) 4 . Daher muss der E-Mail-Konsument idempotent sein – das wiederholte Verarbeiten desselben Events darf nicht zu Duplikat-Mails führen 5 . Die Implementierung erfolgt oft über eine Event-ID (oder Idempotency-Key), die in einer Datenbank oder einem Cache gespeichert wird, sobald das Event verarbeitet ist. Kommt dasselbe Event nochmals rein, erkennt der Service den bekannten Schlüssel und verwirft die Duplikat-Nachricht 5 . Dieses Muster ist unerlässlich, um Kunden nicht versehentlich zweimal dieselbe Mail zu schicken (z.B. zwei Passwort-Reset Links) nur weil ein Retry stattfand.

Workload-Isolation & Priorisierung: In anspruchsvollen Umgebungen lohnt es sich, die Verarbeitung weiter zu unterteilen. Ein erprobtes Pattern ist die Kapselung in drei Schritte 6 7 :

- Data Preparation: Ein Worker bereitet die benötigten Daten vor (falls das Event nicht schon alle Informationen mitliefert). Hier können z.B. zusätzliche Datenbank-Queries stattfinden. Ergebnis ist eine metadata message , die alle Felder für die E-Mail enthält.

- Template Rendering: Ein nachgeschalteter Worker nimmt die Metadata und rendert damit das E-Mail-Template (HTML/Text). Das Ergebnis ist der fertig befüllte E-Mail-Body.

- Sending: Ein dritter Prozess versendet die Mail über den Mailserver/Provider und loggt den Erfolg oder Fehler. Bei Erfolg wird die Nachricht z.B. ins Archiv verschoben, bei Fehlschlag ggf. auf einen Error-Queue gelegt 8 .

Durch diese Aufteilung können Engpässe separat skaliert werden – z.B. mehr Template-Renderer, falls das Rendering aufwändig ist – und verschiedene Mailtypen über eigene Queues priorisiert werden 9 . So werden kritische Transaktionsmails (Passwort-Reset) nicht von volumintensiven Bulk-Mails (wie wöchentliche Reports) ausgebremst. Naukri.com berichtet etwa, dass sie für jeden Mailtyp separate RabbitMQ-Queues nutzen, um jede Kategorie gleichberechtigt und zügig zu behandeln 7 . Solche Architekturen können Millionen von E-Mails pro Tag verarbeiten und dennoch near-real-time Auslieferung sicherstellen 10 .

Implementierung: TypeScript/JavaScript und Python

Die oben skizzierte Architektur lässt sich mit gängigen Tech-Stacks umsetzen. Schauen wir uns zwei Beispiele an – eines mit Node.js/TypeScript und eines mit Python – um ein Gefühl für die Implementierung zu bekommen.

Beispiel 1: Node.js basierter Event-Listener

Angenommen, wir möchten auf Stripe-Webhooks hören und bei bestimmten Events E-Mails versenden. Mit Express.js könnten wir einen Webhook-Endpunkt definieren:

// TypeScript/Node.js - Stripe Webhook Handler (vereinfachtes Beispiel) import express from 'express'; import { sendMail } from './mailService'; // fiktive Mail-Versandfunktion import { EventEmitter } from 'events'; const app = express(); app.use(express.json()); // Body als JSON interpretieren // Ein EventEmitter fungiert hier als einfaches Event-Bus-Beispiel const eventBus = new EventEmitter(); // Event-Consumer registrieren eventBus.on('invoice.payment\_failed', async (event) => { const { customer\_email, invoice\_pdf } = event.data; // Idempotenz-Prüfung (z.B. Redis or In-Memory Cache, hier stark vereinfacht) if (alreadyProcessed(event.id)) return; markProcessed(event.id); // E-Mail-Template füllen und senden const subject = 'Zahlung fehlgeschlagen - bitte aktualisieren Sie Ihre Karte'; const body = `Hallo, leider konnte Ihre letzte Zahlung nicht verarbeitet werden. Bitte aktualisieren Sie Ihre Zahlungsinformationen: ${invoice\_pdf}`; await sendMail(customer\_email, subject, body); console.log(`Dunning-E-Mail an ${customer\_email} versendet.`); }); // Stripe Webhook Endpoint app.post('/stripe-webhook', (req, res) => { const event = req.body; // Hier würde man die Signatur prüfen (Stripe-Security) – ausgelassen für Kürze eventBus.emit(event.type, event); // Event ins System einspeisen res.sendStatus(200); }); app.listen(3000, () => console.log('Webhook server listening'));

In diesem (vereinfachten) TypeScript-Snippet empfangen wir Stripe-Events per HTTP und emitten sie auf einen internen eventBus . Der Listener für invoice.payment_failed bereitet eine Dunning-E-Mail vor. Beachte die Idempotenz-Prüfung : Bevor die Mail gesendet wird, speichern wir die event.id in einer (hier hypothetischen) Liste bereits verarbeiteter Events. So verhindern wir Doppelversand, falls Stripe das Event erneut schickt oder unser Server es doppelt empfängt. Stripe sendet Webhooks nämlich mehrmals, wenn nicht zügig ein HTTP-200 als Bestätigung zurückkommt – ein häufiges Szenario bei kurzen Netzwerkausfällen. Mit einer Idempotenzstrategie bleibt das Ergebnis dennoch konsistent (ein Kunde erhält genau eine Fehlermeldung-E-Mail). Wie Stripe selbst dokumentiert, kann man die Standard-E-Mails von Stripe deaktivieren und stattdessen per Webhook eigene Mails versenden 11 – unser Beispiel demonstriert genau dieses Prinzip.

In der Praxis würde man statt eines simplen EventEmitter eher einen robusten Message-Broker einsetzen und die Idempotenz z.B. mit Redis oder einer Datenbank absichern. Dennoch zeigt das Beispiel den Kern: Node.js eignet sich hervorragend für Echtzeit-Webhook-Handling dank Event-Loop und asynchroner I/O. Mit TypeScript bekommt man dazu Typensicherheit beim Event-Aufbau (etwa event.type als Literal-Union). Für die E-Mail-Komponente könnte man Node-Libraries wie nodemailer oder die APIs der E-Mail-Provider nutzen.

Beispiel 2: Python basierter E-Mail-Worker

Nun betrachten wir einen Python-Ansatz – etwa ein Worker, der über eine Nachrichtenschlange Events erhält. Python bietet mit seiner klaren Syntax und mächtigen Bibliotheken eine gute Grundlage für Batch- und Hintergrundprozesse. Nehmen wir an, wir verwenden eine RabbitMQ-Queue für Events und pika (RabbitMQ-Client für Python):

# Python 3 - Event Consumer Worker (vereinfachtes Beispiel) import json import pika from email.utils import formataddr from smtplib import SMTP def send\_mail\_smtp(to\_address, subject, body): with SMTP('smtp.mailprovider.com') as smtp: smtp.login('api-key', 'secret') from\_addr = formataddr(("My SaaS App", "no-reply@myapp.com")) msg = f"Subject: {subject}\r\nFrom: {from\_addr}\r\nTo: {to\_address}\r\n\r\n{body}" smtp.sendmail(from\_addr, [to\_address], msg) def process\_event(ch, method, properties, body): event = json.loads(body) event\_type = event.get('type') event\_id = event.get('id') # Idempotency check (simplified example using a global set) if event\_id in processed\_ids: ch.basic\_ack(delivery\_tag=method.delivery\_tag) # acknowledge to remove from queue return processed\_ids.add(event\_id) try: if event\_type == 'UserSignedUp': user = event['data']['user'] # e.g. {'email': ..., 'name': ...} subject = f"Willkommen bei {event['data']['product\_name']}!" body = f"Hallo {user['name']},\nschön, dass Sie sich registriert haben..." send\_mail\_smtp(user['email'], subject, body) print(f"Welcome email sent to {user['email']}") # ... weitere Event-Typen behandeln ... ch.basic\_ack(delivery\_tag=method.delivery\_tag) except Exception as e: print(f"Error processing event {event\_id}: {e}") # Optional: NACK ohne requeue oder schreiben in Dead Letter Queue ch.basic\_nack(delivery\_tag=method.delivery\_tag, requeue=False) # Setup RabbitMQ connection and start consuming connection = pika.BlockingConnection(pika.ConnectionParameters('localhost')) channel = connection.channel() channel.queue\_declare('events\_queue', durable=True) channel.basic\_qos(prefetch\_count=1) channel.basic\_consume('events\_queue', on\_message\_callback=process\_event) print(" [\*] Waiting for events. To exit press CTRL+C") channel.start\_consuming()

Hier lauscht der Python-Worker auf einer Queue namens events_queue . Jedes eingehende Event wird als JSON verarbeitet. Wir extrahieren event_type und verzweigen entsprechend: Beim Event UserSignedUp ziehen wir z.B. die E-Mail-Adresse und den Namen des Users aus event['data'] und senden eine Willkommensmail über SMTP. Wieder gibt es eine Idempotenzprüfung ( processed_ids Set). Im Fehlerfall (Exception beim Verarbeiten) wird das Event mit basic_nack verworfen – in einer realen Anwendung würde man es eher auf eine Dead Letter Queue schicken, um es später zu prüfen oder manuelle Maßnahmen zu ergreifen.

Wichtig: Dank channel.basic_qos(prefetch_count=1) holen wir immer nur ein Event pro Worker gleichzeitig aus der Queue. So verhindern wir, dass ein Worker mehrere Mails parallel bearbeiten muss (was z.B. bei Limitierungen des SMTP oder wegen gemeinsamer Ressourcen problematisch sein könnte). Man könnte auch mit Threading oder mehreren Prozessen arbeiten, aber oft ist es einfacher, einfach mehrere Instanzen dieses Workers zu starten, wenn die Last steigt – RabbitMQ verteilt die Events dann im Competing Consumers Pattern automatisch auf die Worker.

Beide Beispiele – in Node.js und Python – zeigen, dass die Umsetzung einer event-getriebenen Mailarchitektur mit gängigen Sprachen gut machbar ist. JavaScript/TypeScript glänzt vor allem beim Empfang von Webhooks oder als Serverless Function (z.B. AWS Lambda) – dank geringer Latenz und JSON-Natur sind Integrationen wie Stripe, Segment & Co. simpel. Python spielt seine Stärken als Worker aus, mit vielen Libraries für E-Mail, Retries (z.B. tenacity für Backoff-Strategien) und einfacher Integration in Data-Pipelines. Letztlich kann man sogar beide Welten kombinieren: z.B. Node für das Webhook-Frontend und Python für die heavy lifting im Backend – durch Events lose gekoppelt, ist Polyglot-Programming kein Problem.

Event-Schema-Design: Idempotenz, Retries & Backoff

Die Gestaltung der Events selbst ist entscheidend für eine robuste Lösung. Ein gutes Event-Schema stellt sicher, dass jedes Ereignis eindeutig identifizierbar, rückverfolgbar und mit minimalem Aufwand zu verarbeiten ist.

Schlüsselbestandteile eines Events: Üblich sind Felder wie id (ein eindeutiger Event-Identifier, z.B. UUID oder ein zusammengesetzter Schlüssel), type (der Ereignistyp, z.B. InvoicePaymentFailed , UserSignedUp ), timestamp (Zeitstempel der Entstehung) und data (ein Objekt mit den relevanten Daten zum Event). Zusätzlich können Metadaten wie source (Welches System hat das Event erzeugt?), correlation_id (zum Verknüpfen zusammenhängender Events in einem Workflow) und retry_count (für interne Zwecke zur Zählung von Wiederholungen) hilfreich sein.

Payload: Vollständige Daten vs. Referenzen: Beim Design der Event-Payload gibt es zwei Ansätze:

- Das Event trägt alle benötigten Informationen für die Mail bereits in sich (z.B. beim Event PasswordResetRequested direkt die E-Mail-Adresse des Nutzers und den Reset-Token-Link). Vorteil: Der Mail-Service muss keine zusätzlichen Datenquellen abfragen – er kann das Event isoliert verarbeiten. Nachteil: Es kann Dateninkonsistenzen geben, wenn die Information schon veraltet ist oder geändert wurde (z.B. Username geändert, aber Event trägt alten Namen) 12 . Zudem bläht eine redundante Payload die Events auf.

- Das Event enthält nur Schlüssel/IDs und minimale Infos, der Mail-Service holt fehlende Details selbst aus einer Datenbank oder API (z.B. nur user_id im Event und der Mailer lädt die aktuelle E-Mail-Adresse aus der Nutzer-DB) 13 . Vorteil: Single Source of Truth – man greift immer auf die neueste Datenbasis zu, was Konsistenz sichert 13 . Auch bleibt das Event-Schema schlank und ist weniger revisionsanfällig. Nachteil: Der Consumer wird komplexer, benötigt Zugriff auf weitere Systeme und die Verarbeitung dauert tendenziell länger (zusätzliche Latenz durch Datenbank-Abfragen).

In der Praxis wählt man oft einen Mittelweg: wichtige Felder (die fast immer gebraucht werden, z.B. email beim PasswordReset) kommen direkt ins Event, während seltene oder sehr umfangreiche Daten (wie ein PDF-Anhang der Rechnung) nur referenziert werden. Unabhängig vom Ansatz ist es wichtig, Versionierung im Event-Schema zu berücksichtigen. Wenn sich Events im Laufe der Zeit ändern (neue Felder, alte Felder entfernt), sollte der Consumer entweder rückwärtskompatibel sein oder über das type /eine version -Property erkennen, wie das Event zu interpretieren ist.

Idempotenz & Deduplizierung: Wie schon im Architektur-Teil erwähnt, sollte jedes Event eine eindeutige Kennung ( id ) besitzen, damit der Consumer Duplikate erkennen kann 5 . Bei integrierten Systemen kommt es vor, dass das gleiche logische Ereignis zwei Events erzeugt – z.B. ein temporärer Fehler im Producer, der beim Wiederanlauf das Event erneut schickt. Ein Idempotency-Key (z.B. die Transaktionsnummer oder ein kombinierter Hash aus bestimmten Feldern) hilft, diese Dubletten auszufiltern. Viele API-basierte Dienste (Stripe, PayPal etc.) liefern schon eine eindeutige Event-ID mit, die man verwenden kann. Andernfalls muss der Entwickler einen geeigneten Schlüssel definieren.

Retry-Strategien: Tritt beim Verarbeiten eines Events ein Fehler auf (z.B. temporärer SMTP-Ausfall, externer API-Call schlägt fehl), sollte das System resilient reagieren. Ein verbreitetes Muster ist Exponential Backoff : den Event eine gewisse Zeit verzögert erneut versuchen, mit zunehmenden Intervallen (z.B. 1 Min, 5 Min, 15 Min...). Diese Strategie verhindert, dass ein persistenter Fehler (z.B. Mailserver down) das System mit ständigen Retry-Versuchen überflutet. Bei Warteschlangensystemen (wie unserem Python/RabbitMQ-Beispiel) kann man z.B. die Nachricht beim NACK in eine spezielle Delay-Queue stellen, die sie erst nach X Sekunden wieder an die Hauptqueue liefert. Einige Broker unterstützen auch Retry-Counts als Header, so dass ein Consumer sehen kann, wie oft ein Event schon versucht wurde, und ggf. ab einer Schwelle anders reagieren kann (z.B. nach 5 Fehlversuchen: Event in Dead Letter Queue verschieben und Alarm auslösen). Wichtig ist: Retries und Idempotenz gehen Hand in Hand – jede Wiederholung muss als solche erkannt und so behandelt werden, dass keine unerwünschten Nebeneffekte entstehen (keine zweite Mail, kein doppelter Datenbankeintrag) 5 .

Beispiel: Unser System versendet Rechnungs-PDFs per E-Mail. Der SMTP-Provider hat kurzzeitig ein Problem und liefert einen Fehler zurück. Der E-Mail-Worker fängt die Exception und plant einen Retry in 5 Minuten. In der Zwischenzeit wird aber das zugrunde liegende Problem behoben. Beim zweiten Versuch klappt der Versand – perfekt. Hätten wir ohne Backoff jede Sekunde einen neuen Versuch gestartet, wäre die Wahrscheinlichkeit hoch, die Rate-Limits des Providers zu triggern oder die Queue mit identischen Events zu füllen. Mit exponentiellem Backoff und Idempotenzprüfung bleibt das System dagegen stabil : wenige wohldosierte Versuche, garantiert nur eine versendete Mail beim ersten Erfolg.

Zusammenfassend sorgt ein durchdachtes Event-Schema mit Eindeutigkeit, Minimalismus und Versionierbarkeit dafür, dass die E-Mail-Workflows verlässlich arbeiten. In verteilten Systemen ist Fehlerfall-Management (Retries, Backoff, Dead Lettering) kein Nice-to-have, sondern Pflicht – aber mit den richtigen Mustern lässt es sich elegant umsetzen.

Template-Management und Versionierung

Die technische Infrastruktur ist die eine Seite der Medaille – doch was nützt sie, wenn die E-Mail-Inhalte selbst schwer zu pflegen sind? Transaktionsmail-Templates müssen oftmals von Produkt- oder Marketingteams angepasst werden (Text, Layout, mehrsprachige Varianten), ohne dass jedes Mal Entwickler in den Code eingreifen. Daher ist ein gutes Template-Management und Versionierungskonzept essenziell.

Trennung von Code und Inhalt: Bewährt hat sich, die E-Mail-Vorlagen separat vom Versendungscode zu halten. Das kann z.B. in Form von Mustache/Handlebars-, EJS- oder Jinja-Templates geschehen, die auf dem Dateisystem oder in einer Datenbank liegen. Der E-Mail-Service lädt zur Laufzeit das Template entsprechend dem Event-Typ und füllt es mit den Daten. Dadurch kann eine Änderung am E-Mail-Text erfolgen, ohne den Service neu zu deployen – etwa indem das Template-File ausgetauscht wird. Manche Teams versionieren Templates in einem eigenen Repository oder CMS, damit auch Nicht-Entwickler Änderungen vorschlagen und testen können (z.B. UX Writer passt Wording an). Wichtig ist, dass der Template-Renderer im Code flexibel bleibt: Neue Platzhalter im Template sollten entweder optional sein oder erfordert ein Update im Code, damit nichts bricht.

Template-Versionierung: Sobald mehrere Templates gepflegt werden, stellt sich die Frage nach Versionierung. Hier zwei Aspekte:

- Inhaltliche Versionierung: Änderungen am Inhalt sollten nachvollziehbar sein (z.B. via Git-History oder zumindest über Zeitstempel/Editor-Infos in einer CMS-Lösung). So kann man bei Bedarf frühere Varianten wiederherstellen – etwa wenn sich herausstellt, dass eine neue Formulierung die Klickrate verschlechtert hat.

- Technische Versionierung: Falls Templates auch die Datenstruktur betreffen (z.B. ein neues Feld wird eingefügt, das der alte Event-Consumer noch nicht bereitstellt), muss eine Kompatibilitätsstrategie her. Entweder man erhöht die Template-ID bzw. Version und der Consumer weiß, welche Template-Version zu welchem Event passt, oder man entwickelt die Templates abwärtskompatibel. In Event-getriebenen Systemen tritt dieser Fall seltener auf, da man eher das Event-Schema erweitert und dem Template neue Felder übergibt, während alte Felder noch vorhanden bleiben. Dennoch sollte man darauf vorbereitet sein, falls z.B. ein drastisches Redesign aller E-Mails erfolgt – möglicherweise möchte man nicht mitten im dunning-Zyklus für einige Kunden das Template wechseln. Dann könnte man übergangsweise zwei Template-Versionen parallel halten (V1 für bestehende Fälle, V2 für neue Fälle) und anhand von Event-Attributen entscheiden, welche Version genutzt wird.

Mehrsprachigkeit und Personalisierung: SaaS-Produkte mit internationaler Kundschaft brauchen oft Mails in mehreren Sprachen. Ein event-getriebenes System kann das gut handhaben, indem im Event oder in den User-Stammdaten die bevorzugte Sprache mitgegeben wird. Der Template-Loader wählt dann die entsprechende Sprachversion. Hier zahlt es sich aus, Template-Dateien systematisch zu organisieren, z.B. nach Sprache: templates/password_reset/en.txt , templates/password_reset/de.txt etc. Sofern das Team experimentierfreudig ist, kann auch A/B-Testing von Templates ein Thema sein. Ohne konkrete Tools zu nennen: einige Unternehmen haben interne Mechanismen, um z.B. zwei Versionen eines Onboarding-Mailtemplates abwechselnd zu versenden und via Tracking die Wirksamkeit zu vergleichen. Das lässt sich auch event-basiert lösen, indem der Template-Service z.B. anhand einer Hashfunktion auf der User-ID eine Variante auswählt (so dass ~50% der Nutzer Template A, der Rest Template B bekommt). Solche Experimente sollten aber wiederum im Template-Management dokumentiert und nachhaltebar sein.

Template-Deployment und QA: Änderungen an Templates sollten zunächst in einer Staging-Umgebung oder via Test-Events geprüft werden. Hier bietet sich an, Seed-Tests durchzuführen – also die neuen Mails an interne Testadressen oder Seed-Listen zu schicken, um Rendering und Spam-Einstufung zu checken. Wie weiter unten noch detaillierter beschrieben, lohnt es sich, kritische Transaktionsmails täglich automatisiert über Seeds zu testen 14 , damit Templateänderungen oder externe Faktorenn (neue Keywords, die Spam-Filter triggern) sofort auffallen.

Abschließend: Ein sauberes Template-Management spart Zeit und Nerven. Nichts ist schlimmer, als in einer heiklen Situation (z.B. rechtliches Update der Inhalte aller Systemmails) erst die Logik entwirren zu müssen, weil Text und Code vermischt sind. Durch Trennung, Versionierung und stringente Prozesse stellt man sicher, dass Transaktionsmails inhaltlich konsistent und aktuell bleiben, ohne die technische Zuverlässigkeit zu gefährden.

Datenquellen-Anbindung: Stripe, Segment & eigene Product-Events

Ein event-basiertes E-Mail-System ist nur so gut wie die Daten, die es auslösen. In modernen SaaS-Stacks gibt es eine Fülle von Event-Quellen : Payment-Provider, Analytics-Systeme, User-Action-Events aus der Applikation – all diese sollten angebunden werden, um relevante und zeitnahe E-Mails zu triggern. Schauen wir uns drei typische Quellen an:

Stripe Webhooks für Billing-Events

Stripe ist ein verbreiteter Zahlungsanbieter in SaaS und bietet von Haus aus Webhooks für Events wie invoice.payment_failed , invoice.paid , customer.subscription.created usw. Diese eignen sich ideal, um Transaktionsmails im Billing-Kontext auszulösen – z.B. Rechnung versandt, Zahlung fehlgeschlagen, Abo gekündigt. Stripe kann zwar auch gewisse E-Mails selbst versenden (Rechnungen, Receipt, expiring card reminders), aber viele Unternehmen deaktivieren das zugunsten eigener Mails mit ihrem Branding 11 .

Die Integration läuft typischerweise so: Man registriert bei Stripe einen Webhook-Endpunkt (z.B. /webhooks/stripe ) und abonniert die gewünschten Event-Typen. Unser System empfängt diese Webhooks (wie im Node.js-Beispiel oben gezeigt) und wandelt sie in interne Events um. Wichtig ist die Authentifizierung der Webhooks (Stripe liefert eine Signatur mit, die man mit dem secret verifizieren sollte, um nicht auf Fake-Requests hereinzufallen). Nach Empfang des Events hat man die Stripe-Eventdaten zur Verfügung, z.B.:

{ "id": "evt\_1F8PG....", "type": "invoice.payment\_failed", "data": { "object": { "customer\_email": "kunde@example.com", "attempted": true, "next\_payment\_attempt": 1695388800, "hosted\_invoice\_url": "https://...stripe.com/invoice/acct\_123...", ... } } }

Diese Daten kann man entweder direkt im Mailtemplate nutzen (z.B. hosted_invoice_url in den CTA-Link einbauen), oder man reichert sie um Infos aus dem eigenen System an (z.B. Kundenname aus der lokalen DB, falls Stripe den nicht hat). Stripe wiederholt Webhooks automatisch mit Backoff (bis zu 72 Stunden), wenn die eigene Endpoint-API keinen 200-OK zurückgibt. Das entlastet uns insofern, da wir im Fehlerfall (Server down o.ä.) uns ums Retry nicht selbst kümmern müssen – wir müssen nur Idempotenz sicherstellen, damit der wiederholte Webhook nicht zur Doppelmail führt (Stripe-Event-ID nutzen!). Ein durchdachter Dunning-Workflow wird mehrere E-Mails zeitversetzt verschicken, solange das Payment offen ist. Man kann entweder Stripe’s Smart Retries nutzen und die E-Mails parallel steuern, oder man implementiert den gesamten Ablauf selbst. In jedem Fall gilt: Payment-Events haben höchste Dringlichkeit , da sie direkt churn-relevant sind. Hier spielt die Echtzeitfähigkeit der Event-Architektur ihren Trumpf aus – der Kunde bekommt Sekunden nach einer fehlgeschlagenen Zahlung die Info und kann reagieren, bevor es zu Serviceunterbrechungen kommt.

Segment und Analytics-Events

Produkt- und Growth-Teams setzen häufig auf Tools wie Segment , um Nutzeraktionen zentral zu erfassen. Segment sammelt Product Events (z.B. "User Invited Teammate" , "Feature X Used" ) und kann diese an verschiedenste Destinations weiterleiten – unter anderem an Webhooks oder direkt an bestimmte APIs. Für unser E-Mail-System kann Segment eine wertvolle Quelle sein: Wenn wichtige In-App -Aktionen erfasst werden, lassen sich daran triggers für E-Mails knüpfen. Beispiele:

- Signup Completed : Ein Nutzer hat die Registrierung abgeschlossen ➜ Trigger Willkommensmail, vielleicht mit Tipps für den Einstieg.

- Password Reset Requested : (Könnte auch direkt vom Backend kommen statt Segment) ➜ Sende Reset-Mail.

- Trial Will Expire Soon : Falls das Produkt einen Trial hat, könnte ein Event 7 Tage vor Ablauf gesendet werden ➜ Trigger “Ihr Trial endet bald, jetzt upgraden”-Mail.

- Feature Usage Milestone : Nutzer hat zum ersten Mal Feature X genutzt ➜ Trigger eine “Glückwunsch, Sie haben X entdeckt!”-Mail mit weiterführenden Infos.

Segment kann solche Events z.B. via Webhook an unser System liefern. Alternativ könnten wir Segment’s Funktionen nutzen, um bestimmte E-Mail-Aktionen direkt auszulösen – aber oft ist es besser, die Events einfach in die bestehende Pipeline einzuspeisen, um alle Transaktionsmails an einer Stelle zu steuern. Der Vorteil : Alle produktbezogenen Events laufen zusammen und können konsistent verarbeitet werden, unabhängig davon ob sie vom eigenen Backend oder via Segment kommen.

Man sollte jedoch aufpassen, Dupplikate zu vermeiden, wenn Segment und Backend evtl. dieselben Events schicken. Ein sauberes Event-Design mit eindeutigem event.id hilft hier ebenfalls. Außerdem bietet Segment die Möglichkeit, Events zu filtern oder anzureichern , bevor sie gesendet werden – etwa nur bestimmte User-Gruppen oder zusätzliche Kontextdaten hinzufügen. Diese Intelligenz kann genutzt werden, um gezielter Mails auszulösen. Letztlich ist Segment ein optional vorgelagerter Event-Hub für externe oder clientseitige Events; unser E-Mail-Service unterscheidet aber im Grunde nicht, ob ein Event von Segment oder direkt vom Produkt kam, solange das Schema passt.

Eigene Product-Event-Pipelines

Viele SaaS-Anwendungen bauen eine eigene Event-Pipeline auf, insbesondere bei Microservice-Architekturen. Das kann z.B. Kafka oder AWS EventBridge sein, worüber Services domänenspezifische Events publizieren und konsumieren. Ein interner Notification Service kann hier subscriben. Denkbar ist auch, dass das Backend bei bestimmten Aktionen explizit einen Aufruf an den Mail-Service macht (eine Art E-Mail API ). Der Nachteil einer direkten API-Integration ist allerdings wieder die Kopplung – schöner ist es, wenn das Backend einfach ein Event feuert („User X hat Y getan“) und der Mail-Service reagiert, ohne dass beide direkt miteinander integriert sind.

Ein Beispiel: Bei Passwort-Reset könnte das User-Service nach erfolgreicher Anforderung ein Event PasswordResetRequested mit UserID, ResetToken etc. in einen Event-Bus schreiben. Der Mail-Service empfängt es und sendet die entsprechende Mail. So kann auch dasselbe Event ggf. noch woanders genutzt werden (z.B. um in der UI einen Hinweis zu loggen oder ein Security-Monitoring zu informieren). Echtzeitnähe ist dabei gegeben – Events werden in der Regel innerhalb von Sekunden oder weniger übertragen.

Wichtig in eigenen Pipelines ist, dass man Monitoring hat: Man will keine Events „verlieren“. Tools wie Kafka ermöglichen auch das Nachholen von Events (Replay), falls ein Consumer längere Zeit down war. Für Transaktionsmails ist ein mindestens einmal Zustellungsmodell akzeptabel (daher Idempotenz beachten). Die Kombination aus Outbox-Pattern im Producer und idempotentem Consumer stellt sicher, dass kein Event unter den Tisch fällt, aber auch nichts doppelt Wirkung zeigt 4 .

Datenanreicherung und Single Source of Truth: Oft sitzt der Mail-Service an der Schnittstelle verschiedener Datenquellen. Beispiel: Ein InvoicePaid -Event kommt von Stripe mit Grunddaten zur Rechnung, aber für die E-Mail will man auch den aktuellen Account-Stand aus der eigenen Datenbank hinzufügen (z.B. Restguthaben, neuen Plan etc.). Hier zahlt es sich aus, dass der E-Mail-Service als eigenständiger Consumer Zugang zu mehreren Datenquellen haben kann – natürlich mit Bedacht auf Latenz und Fehlerbehandlung. Eine Alternative ist das Vorbereiten aller Daten im Event (siehe Diskurs oben, Include all attributes vs. keys 12 ). Viele verfolgen einen hybriden Ansatz: Das Event enthält IDs, und ein vorgelagerter Schritt (Data Enrichment Worker) holt die restlichen Infos und baut eine komplette E-Mail-Payload. Das war im Naukri-Architekturbeispiel der Data generation worker 15 . So bleibt die letzte Stufe (Mail versenden) wieder simpel und schnell.

Zusammengefasst: Unser Transaktionsmail-System sollte möglichst viele relevante Event-Quellen anbinden, um Nutzern zum richtigen Zeitpunkt die richtige Information zu senden. Ob Stripe, Segment oder eigene Events – wichtig ist die Normalisierung ins interne Schema und eine verlässliche Zustellung . Dank Webhooks und Streaming ist das heutzutage gut machbar. Jedes neue Event-Typ kann relativ einfach integriert werden, ohne das Rad neu zu erfinden – man hängt sich einfach an den Event-Strom an.

QA & Testing: Seed-Tests, Staging vs. Production, Alerting

Bei aller Automatisierung darf die Qualitätssicherung nicht zu kurz kommen. Transaktionale E-Mails sind oft geschäftskritisch – fällt z.B. die Passwort-Reset-Mail aus, können Nutzer sich nicht einloggen, was sofort Supporttickets erzeugt. Umso wichtiger ist es, das System laufend zu testen und bei Problemen schnell Alarm zu schlagen.

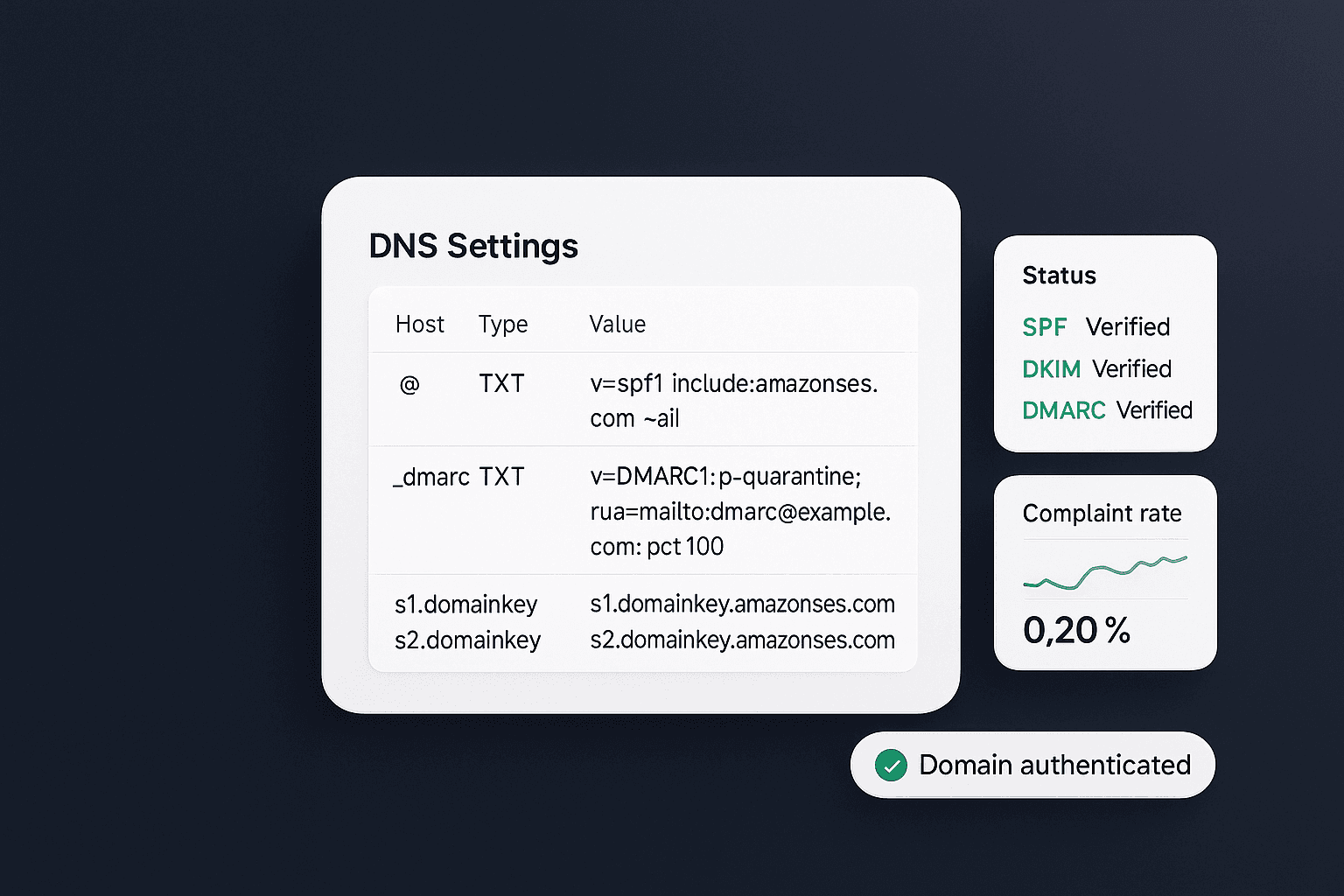

Staging vs. Production: Realitätsnahe Tests ohne Nebenwirkungen

Ein Staging-Umgebung für das E-Mail-System ist praktisch Pflicht. Hier kann man mit echten Events (aus einer Sandbox-Datenbank oder simulierten Webhooks) den gesamten Fluss testen, ohne echte Kunden anzuschreiben . In Staging sollten die E-Mails entweder an interne Testadressen gehen oder gar nicht wirklich versendet werden (manche nutzen z.B. einen Dummy-SMTP-Server wie MailHog , der Mails abfängt). Wichtig ist, dass Staging und Produktion klar getrennt sind: API-Keys der E-Mail-Provider, DNS-Einstellungen etc. – nichts darf sich überschneiden, damit nicht versehentlich Test-Mails an Kunden rausgehen. Viele E-Mail-Provider unterstützen Sandbox-APIs oder dedizierte Test-Modi; alternativ kann man im Code einen Schalter einbauen à la if ENV=staging, override recipient with dev-team@mycompany.com . So landet jede Transaktionsmail aus Staging gesammelt im Postfach des Dev-Teams.

Daten in Staging: Um realistische Tests zu fahren, sollten die Events in Staging echte Beispielpayloads enthalten. Für Stripe z.B. kann man die Stripe-Test-API nutzen und Webhooks an Staging senden lassen. Für eigene Events kann man anonymisierte Dump-Daten einspielen, so dass z.B. ein Event UserSignedUp mit einem echten aussehenden (aber test) Nutzer durchgeht. Das stellt sicher, dass Templates korrekt befüllt werden und keine Platzhalter fehlen.

Seed-Tests und Deliverability-Monitoring

Neben dem funktionalen Testing (kommt das Event an? wird die Mail generiert?) muss auch die Zustellbarkeit im Blick bleiben. Hier kommen sogenannte Seed-Tests ins Spiel. Ein Seed ist eine Test-E-Mail-Adresse, meist Teil einer ganzen Liste unterschiedlicher Provider (Gmail, Outlook, Yahoo, GMX, Firmen-Domains etc.), die man in die Verteiler aufnimmt. Bei normalen Newsletter-Kampagnen hängt man diese Seeds einfach an den Verteiler. Doch bei triggered Emails – also einzelnen Transaktionsmails – geht das nicht so ohne Weiteres, schließlich werden diese 1:1 an einen Nutzer verschickt, nicht an eine Liste. Die Lösung: Man simuliert diese Events für die Seed-Adressen . Das heißt, man bringt die Anwendung dazu zu glauben, all diese Seed-Nutzer hätten die entsprechende Aktion ausgelöst 16 . Im Hintergrund verschickt das System dann an jede Seed-Adresse ein Exemplar der Mail.

Ein Beispiel aus der Praxis: Man möchte täglich prüfen, ob die Passwort-Reset-Mail korrekt zugestellt wird. Dazu legt man in der Test-Datenbank z.B. 5 Dummy-User mit Seed-Adressen an (eine Gmail, eine Yahoo, etc.). Ein kleines Script triggert für jeden Dummy-User einen Passwort-Reset-Request, wodurch das System 5 Passwort-Reset-Mails – eine an jede Seed – sendet 16 . Anschließend prüft man mit einem Monitoring-Tool (oder manuell), ob diese Mails angekommen sind, und vor allem wo: Posteingang oder Spam. Viele Unternehmen setzen hierfür Tools von Drittanbietern ein, die die Postfächer dieser Seeds überwachen und Reports liefern. So erfährt man zeitnah , wenn z.B. plötzlich die Mails bei Gmail im Spam landen, oder wenn sie gar nicht ankommen (was auf Blockierungen oder technische Probleme hindeuten kann). Laut Experten sollten alle wichtigen Trigger-Mails täglich so getestet werden (auch am Wochenende) 14 , denn bereits ein einziger Tag Zustellprobleme bei z.B. Account-Bestätigungen kann hunderte verlorene Signups bedeuten.

Neben Spam/Inbox-Placement prüft man mit Seed-Tests auch Renderings: Sehen die Mails in verschiedenen Mailclients korrekt aus? Stimmen Links und Tracking-Parameter? Gerade nach Template-Updates ist das wertvoll. Und da Transaktionsmails oft über Jahre laufen, schleichen sich sonst unbemerkt Fehler ein – die Seed-Mails sind wie ein Frühwarnsystem.

Alerting bei Fehlern

Trotz aller Prävention können Fehler passieren – und dann ist schnelles Reagieren gefragt. Deshalb gehört ein Monitoring & Alerting -Konzept zur E-Mail-Infrastruktur. Einige Punkte, die man überwachen sollte:

- Event-Backlogs: Wenn z.B. die Queue-Länge ungewöhnlich ansteigt, bedeutet das, dass Events nicht zügig verarbeitet werden. Das könnte auf einen hängen gebliebenen Worker oder einen Performance-Engpass hindeuten. Ein Alert bei z.B. >1000 wartenden Events oder bei einer kontinuierlich wachsenden Warteschlange über 5 Minuten hilft dem DevOps-Team, rechtzeitig einzugreifen (z.B. Worker skalieren oder prüfen, ob ein Absturz vorliegt).

- Versandfehler-Quote: Schlägt das Senden von E-Mails wiederholt fehl (z.B. API-Antworten mit Fehlercode, SMTP timeouts), sollte ein Alarm ausgelöst werden. Mögliche Ursachen: Das E-Mail-Provider-Konto ist gesperrt/über Limit, DNS-Probleme, Netzwerkstörungen. Hier will man nicht erst nach Tagen durch Supporttickets davon erfahren.

- Bounce/Complaint Rate: Viele E-Mail-Services liefern Events/Webhooks für Bounces (unzustellbar) und Complaints (Nutzer markiert Mail als Spam). Wenn diese Raten plötzlich steigen, ist Alarmstufe rot: Möglicherweise gab es einen Fehler (z.B. wurden versehentlich alte inaktive Adressen beschickt, oder ein Mailing ging irrtümlich mehrfach raus). Auch eine signifikante Spam-Complaint-Zahl kann auf ein inhaltliches Problem hindeuten (falscher Inhalt, missverständlicher Absender etc.). Solche Metriken sollte man automatisiert tracken und ab einem Schwellwert eine Slack- oder E-Mail-Benachrichtigung an das Team schicken.

- Integrationsfehler: Falls unser System auf externe APIs zugreift (z.B. um Daten anzureichern), sollten deren Fehler ebenfalls beobachtet werden. Z.B. wenn der User-Datenbank-Call permanent fehlschlägt (DB down), kommen Mails unvollständig raus oder können nicht gesendet werden. Hier kann z.B. ein Error-Logging (z.B. in Sentry oder CloudWatch) mit Alarm genutzt werden, oder man implementiert im Code proaktive Alerts ("wenn 10 Events in Folge Fehler erzeugen, sende Alert-Event XY").

In der Entwicklung sollte man zudem automatisierte Tests für die E-Mail-Logik haben. Unit-Tests fürs Template Rendering (z.B. ob alle Platzhalter ersetzt werden, gegeben Dummy-Daten) fangen simple Fehler auf. Integrationstests, die einen Beispiel-Event durch den Pipeline-Flow schicken (ggf. mit einem Mock-Email-Backend), sind Gold wert, um bei Codeänderungen Regressionen zu vermeiden.

Zusammengefasst: Ein solides Testing- und Monitoring-Setup sorgt dafür, dass Transaktionsmails unscheinbar zuverlässig im Hintergrund funktionieren. Die Nutzer merken im Idealfall gar nicht, welcher Aufwand dahintersteckt – sie bekommen einfach ihre Mails. Und das Team kann ruhig schlafen, weil es weiß: Wenn doch mal etwas klemmt, wird es sofort bemerken und beheben können.

Event-Driven Journey Builder: Mehrstufige Automationen ohne Limits

Bislang haben wir einzelne Transaktions-E-Mails betrachtet. Doch oft will man Benutzer mit einer ganzen Journey begleiten: eine Sequenz von Mails und Aktionen, ausgelöst durch Events und abhängig vom Nutzerverhalten. Gängige Marketing-Automation-Tools bieten hierfür Journey Builder oder Workflow Automation an – allerdings stoßen Teams dabei oft an Grenzen. Typische Klagen: Eingeschränkte Logik (keine verschachtelten Bedingungen oder komplexen Trigger-Kombinationen) 17 , Schwierigkeiten bei der Integration von Live-Produktdaten , oder Verzögerungen durch Sync-Prozesse. Genau hier kann ein eigener eventgetriebener Journey Builder glänzen 18 .

Was bedeutet Journey Builder in diesem Kontext?

Statt nur one-off Events → Mail, sprechen wir von definierten Flows: z.B. Onboarding-Journey , Churn-Prevention-Journey , Reaktivierungs-Journey . Ein Journey Builder ist im Grunde eine Engine, die Regeln verwaltet wie “Wenn Event A passiert, starte Sequenz X: schicke Mail1 sofort, dann warte 3 Tage. Ist bis dahin Event B nicht passiert, schicke Mail2, sonst brich ab.” Solche mehrstufigen Programme lassen sich natürlich auch hart kodieren, aber ein flexibles System erlaubt dem Produkt- oder Growth-Team, diese Abläufe zu konfigurieren, ohne für jede Änderung Entwicklercode anfassen zu müssen.

Grenzen typischer Tools und der Vorteil eigener Lösungen

Warum nicht einfach ein vorhandenes Marketing-Automation-Tool nutzen? Nun, viele SaaS-Unternehmen probieren das – und stoßen dabei auf Integrations- und Skalierungsprobleme . Externe Tools sind häufig nicht nahtlos mit dem Produktbackend verbunden : Man muss erst Daten rüberschaufeln (z.B. einen täglichen Sync der User-Datenbank, oder Events per Webhook an das Tool senden). Das führt zu Latenzen oder Datenlücken. Außerdem sind komplexe Bedingungen (“schicke Mail nur, wenn User hat Feature X genutzt UND Plan = Trial UND …”) oft nur umständlich abbildbar oder gar unmöglich, wenn das Tool die nötigen Attribute nicht kennt. Benutzer berichten, dass sie verschachtelte Abläufe vermissen, etwa fehlende mehrstufige If/Else oder begrenzte A/B-Test-Fähigkeiten 17 .

Mit einer in-house event-driven Journey Engine , die direkt auf die Produkt-Events hört, umgeht man diese Hürden. Unser System hat ja bereits Zugriff auf alle Events und Datenquellen – wir können also in Regeln alle erdenklichen Kombinationen nutzen. Ein Event-Driven Journey Builder, der sich nahtlos an die Produktdaten anstecken lässt, schließt die oft beklagten Integrationslücken 18 . Die Vision ist, dass Produktmanager z.B. direkt sagen können: “Wenn Nutzer Feature X 30 Tage nicht genutzt hat, und kein Support-Ticket offen ist, dann triggere eine Re-Engagement -Mail, und falls er danach immer noch inaktiv ist, markiere ihn für Sales-Outreach.” – Solche customer lifecycle spezifischen Abläufe werden zum Wettbewerbsvorteil, sind aber in von-der-Stange-Lösungen kaum abbildbar.

Umsetzung eines eigenen Journey Builders

Die konkrete Umsetzung kann je nach Ressourcen unterschiedlich ausfallen. Einige Ansätze:

- Rule Engine: Man baut eine Konfigurationsdatei oder UI, in der Events und Bedingungen mit Aktionen verknüpft werden. Unter der Haube wertet ein Worker kontinuierlich Events aus, aktualisiert Zustände (z.B. “User X ist in Journey Y bei Schritt 2”) und entscheidet, welche Aktion als nächstes kommt. Ein einfaches Beispiel: Beim Event SignupCompleted wird User X in die Journey “Onboarding” Schritt 0 gesetzt. Der Journey-Worker schickt sofort Mail 1. Er plant gleichzeitig eine Art Timer-Event in 3 Tagen (“Check Onboarding Step1 for User X”). Wenn dieser Timer feuert und sieht “User X hat Event AppOpened noch nicht getriggert”, dann schickt Mail 2, sonst bricht ab. Hier sieht man: Der Journey Builder erzeugt selbst wieder Events (Timer/Check-Events), die ins System fließen.

- State Machine Workflow: Man kann den Journey-Ablauf auch als zustandsbasierte Maschine modellieren. Jeder Nutzer hat pro Journey einen State (z.B. ONBOARDING_STEP1_SENT , ONBOARDING_COMPLETED etc.). Events (User-Aktionen oder Timer) führen Transitionen aus. Dieses Konzept lässt sich in Datenbank-Tabellen oder spezialisierten Workflow-Engines abbilden. Es stellt sicher, dass auch parallel laufende Journeys pro User getrennt verfolgt werden können.

- Integration ins Event-System: Interessanterweise kann man auch das bestehende Event-System selbst als Orchestrator nutzen: Einige Patterns nutzen z.B. Event-Sourcing -ähnliche Mechanismen, wo Folgeereignisse geplant werden. Beispiel: Unser Mailservice könnte bei bestimmten Events direkt weitere Events schedulen – im Sinne von “Mail1 gesendet ➜ emit onboarding.mail1.sent Event”. Ein separater Scheduler-Service hört auf solche Events und erzeugt mit Delay neue Events (“mail1.sent für User X ➜ plane in 3 Tagen Event onboarding.step1.check ”). So bleibt alles im Event-Paradigma, und dennoch passiert eine orchestrierte Abfolge.

Wichtig ist bei all dem, dass man Fehler und manuelle Eingriffe berücksichtigen muss. Ein Journey Builder muss z.B. damit umgehen, wenn ein Nutzer zwischendrin doch das Ziel erreicht (dann Journey abbrechen), oder wenn ein Schritt fehlschlägt (Mail konnte nicht zugestellt werden – was tun? Evtl. doch weiter versuchen oder in anderen Kanal wechseln). Hier kann die eigene Implementierung punkten, weil sie genau auf die Produktanforderungen zugeschnitten ist – während generische Tools oft Lücken lassen.

Realitätscheck: Natürlich bedeutet der Aufbau eines eigenen Journey Builders Aufwand. Aber für wachsende SaaS mit anspruchsvollen Engagement-Kampagnen lohnt es sich. Die interne Research hat gezeigt, dass kein bestehender Anbieter perfekt sowohl Entwickler-Transaktionsmails als auch Marketer-Journeys abdeckt – es gibt hier eine Lücke für eine Plattform, die beides nahtlos vereint 19 18 . Ein Event-Driven Journey Builder, der direkt in die Produkt-Event-Pipeline integriert ist, könnte genau diese Lücke schließen, indem er robuste Developer-Features (APIs, Webhooks, Logging) mit der Flexibilität eines Marketing-Tools verbindet. Kunden wünschen sich “automations that plug into product data seamlessly” 18 , und genau das erreicht man, wenn das Journey-System Teil der eigenen Backend-Infrastruktur ist.

Ein greifbares Beispiel zum Abschluss: Stellen wir uns Alice , eine Product Marketer, vor. Sie möchte eine Upgrade-Journey bauen: Alle Nutzer im Free-Plan, die nach 14 Tagen bestimmte Premium-Features ausprobiert haben, sollen eine Upsell-Mail bekommen. In unserem Event-System kommen Events rein wie FeatureUsed mit Plan-Status. Alice definiert nun im Journey Builder: Entry Condition: Event FeatureUsed AND user.plan == free AND event.feature IN PremiumFeature2 . Aktion: Sende Upsell-Mail (mit dynamischem Content je nach Feature). Follow-up: 7 Tage später, wenn Nutzer noch free ist und ein zweites Event FeatureUsed auf premium Feature hat, sende Erinnerung oder Rabatt-Angebot, ansonsten Ende. – Diese Journey hätte mit Standard-Marketing-Tools vermutlich zig Workarounds gebraucht (Datenexport, komplexe Segmentierung...). In unserem integrierten System war es eine Konfigurationssache, da alle nötigen Daten als Events vorlagen. Die Mails gehen just-in-time * nach den echten Nutzungsereignissen raus, was die Conversion deutlich steigern dürfte.

Fazit und Takeaways

Event-getriebene Transaktionsmails sind ein mächtiger Hebel, um Nutzer effizient und personalisiert anzusprechen. Zusammenfassend die wichtigsten Erkenntnisse und Best Practices:

- Echtzeit durch Entkopplung: Durch ein event-getriebenes Design werden E-Mails nahezu in Echtzeit versendet, ohne die Hauptanwendung zu blockieren. Produzenten (z.B. Billing-System) und Konsumenten (Mail-Service) sind lose gekoppelt und skalieren unabhängig 1 . Das erhöht die Ausfallsicherheit und Performance signifikant.

- Robuste Event-Verarbeitung: Ein sauberes Event-Schema mit eindeutigen IDs und minimal nötiger Payload legt die Basis. Idempotenz ist Pflicht – der Mail-Consumer muss doppelte Events erkennen und ignorieren 5 . Kombiniert mit durchdachten Retry- und Backoff-Strategien bleibt das System auch in Fehlerfällen konsistent und spammt Nutzer nicht mit Dubletten voll.

- Template-Management & Versionierung: Trennen Sie E-Mail-Templates vom Code und verwalten Sie sie versioniert. So können Inhalte schnell angepasst werden, ohne die Versandlogik zu gefährden. Tests neuer Templates auf Staging und per Seed-Mails stellen sicher, dass Änderungen fehlerfrei und deliverability-freundlich sind.

- Nahtlose Datenintegration: Nutzen Sie alle relevanten Datenquellen – von Stripe-Webhooks über Segment-Events bis zu internen Event-Pipelines –, um Transaktionsmails zum richtigen Zeitpunkt mit den richtigen Infos zu füttern. Gerade bei Stripe Dunning (fehlgeschlagenen Zahlungen) lohnt sich eine eigene Umsetzung: Stripe kann zwar Standardmails senden, aber mit Webhooks und eigenem Template sind Markenauftritt und Flexibilität höher 11 . Einheitliche Events aus verschiedenen Quellen ermöglichen einen 360°-Blick auf den Nutzer.

- Testing & Monitoring sind essenziell: Führen Sie regelmäßige Seed-Tests für alle kritischen Trigger-Mails durch, idealerweise täglich 14 . So erkennen Sie Zustellprobleme oder Renderingfehler sofort. Halten Sie Staging-Umgebungen vor, um gefahrlos Workflows zu erproben. Etablieren Sie Alerting für Fehler, Queue-Stau, hohe Bounce-Raten etc., damit das Team proaktiv eingreifen kann – bevor es Kunden merken.

- Journey Automation ohne Limits: Überlegen Sie, ob ein eigener Event-Driven Journey Builder für Ihr Produkt sinnvoll ist. Wenn die Anforderungen an kundenindividuelle, mehrstufige E-Mail-Flows die Möglichkeiten gängiger Tools übersteigen (und das tun sie oft, gerade was die Integration von Live-Produktdaten angeht 17 ), kann eine in-house Lösung zum Gamechanger werden. Ein Journey Builder, der direkt an der Event-Pipeline hängt, beseitigt die üblichen Automations-Limits und Integrationshürden 18 – und verschafft Ihrem Team maximale Kontrolle über die User Journey.

Abschließend: Transaktionale E-Mails mögen unscheinbar wirken, doch „it just works” kommt nicht von ungefähr – es erfordert durchdachte Architektur und Liebe zum Detail. Die hier beschriebenen Patterns und Best Practices helfen Ihnen, Ihre Kommunikation verlässlich, skalierbar und zielgenau aufzusetzen. Damit begeistern Sie Nutzer, reduzieren Churn (man denke an perfekt getimte Dunning-Mails) und schaffen die Grundlage für personalisierte Journeys, die Ihr SaaS-Angebot positiv hervorstechen lassen. Event-getriebene Transaktionsmails sind somit nicht nur technisch elegant, sondern auch ein strategischer Vorteil für wachstumsorientierte Produkt- und Engineering-Teams. Viel Erfolg bei der Umsetzung!

Quellen: Die oben genannten Empfehlungen und Beispiele stützen sich auf aktuelle Best Practices und Erfahrungen aus der SaaS-Branche, u.a. Dokumentationen und Leitfäden zur Event-Architektur 1 12 , Patterns zur Idempotenz in verteilten Systemen 5 , Fallstudien großer Plattformen 7 8 sowie interne Recherchen zu Kundenbedürfnissen im E-Mail-Bereich 18 17 . Weiterführende Informationen finden sich in Stripes Entwickler-Dokumentation (Webhooks & Custom Emails) 11 und Blogbeiträgen zu E-Mail Testing und Dunning-Strategien 14 . Diese Insights unterstreichen die Relevanz eines durchdachten, event-getriebenen Ansatzes für transaktionale E-Mails in modernen SaaS-Produkten.

2 3 4 5 Pattern: Transactional outbox

6 7 8 9 10 15 Email Sending Architecture Using Messaging Queue | by Naukri Engineering | Naukri Engineering | Medium

11 Send customer emails | Stripe Documentation

14 16 How Do I Seed Test My Triggered Email? | Validity Blog

17 Long-Term Blog & Content Strategy for an AI-Powered Customer Email Platform.pdf

file://file-TvUfofu1HgTUVDQTCFKPC5

18 19 Customer Email Platform Pain Points & Opportunities.pdf

file://file-KDkvKmFLUTBC7U2Cgi59GH